c++

arcgis

unix

spring cloud

DDIM

r语言

Cartographer

ChatGPT国内

ps

互联网

autoregressive

ue4

Cookie

PMP项目管理

数字IC设计

OKR

UI开发

证件照

非线性函数拟合

opc

缩放点积注意力机制

2024/4/13 16:14:05深度学习笔记之Transformer(二)关于注意力分数的总结

深度学习笔记之Transformer——关于注意力分数的总结 引言回顾: Nadaraya-Watson \text{Nadaraya-Watson} Nadaraya-Watson核回归再回首: Seq2seq \text{Seq2seq} Seq2seq中的注意力机制注意力机制的泛化表示加性注意力机制缩放点积注意力机制 引言

上一…

机器学习笔记 - 通过一个例子来快速理解自注意力机制/缩放点积注意力机制

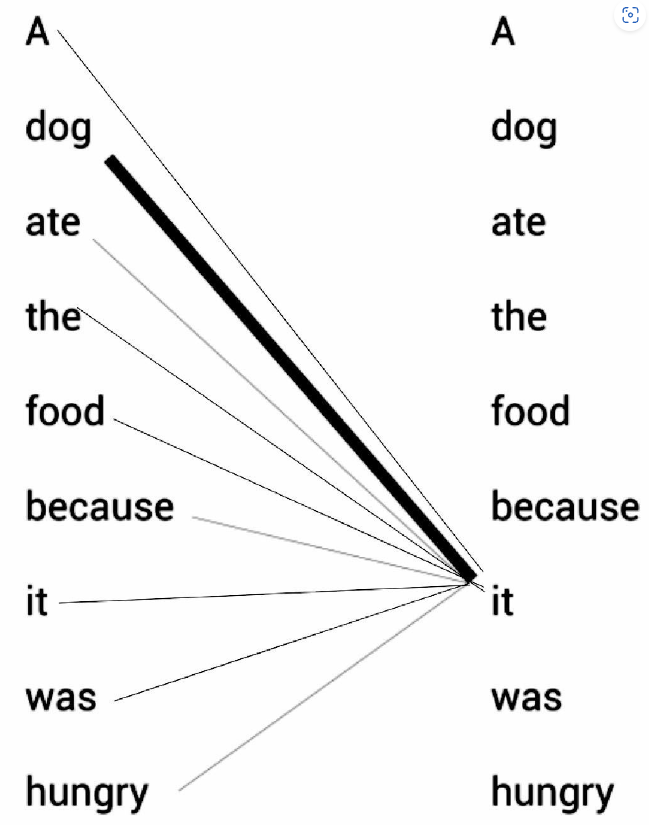

一、一个简单的示例 请看下面的例句:A dog ate the food because it was hungry(一只狗吃了食物,因为它很饿) 例句中的代词it(它)可以指代dog(狗)或者food(食物)。当读这段文字的时候,我们自然而然地认为it指代的是dog,而不是food。但是当计算机模型在面对这两种选…